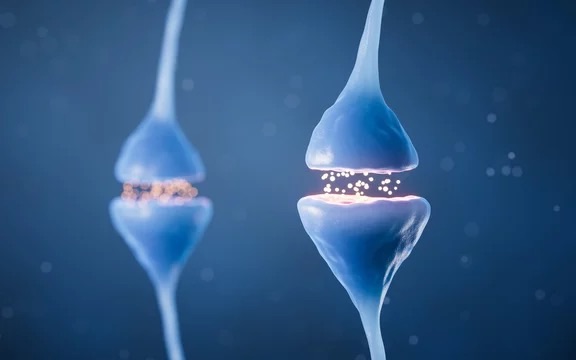

人間の脳は、約860億個の神経細胞(ニューロン)と、それらを結びつける無数のシナプスによって構成されています。この膨大なネットワークが、私たちの記憶を蓄え、思考を生み出し、日々の行動を支えているのです。この仕組みは非常に複雑で、科学者たちは古くからその謎に迫ろうと研究を重ねてきました。では、具体的にどのようにして脳が情報を処理し、記憶を保持しているのでしょうか。本記事では、脳と記憶に関する重要な数学モデルをご紹介し、それぞれの数式が何を意味しているのかを丁寧に解説していきます。少し専門的な内容もありますが、できるだけわかりやすくお伝えしますので、一緒に学びを深めていきましょう。

1. ニューロンの発火とシナプス結合

1.1 ニューロンの発火モデル(ホジキン・ハクスリー方程式)

この方程式にはいくつかの変数が含まれています。それぞれの意味を一つずつ確認していきます。

- :膜容量(細胞膜の電気的な容量)

これは、ニューロンの細胞膜がどれだけの電気を蓄えられるかを表します。例えるなら、電池の容量のようなものです。 - :膜電位(ニューロン内部と外部の電位差)

ニューロンの内外で電気がどれだけ異なるかを示します。この値が変化することで発火が起こります。 - :外部からの電流(シナプスや電極による刺激)

他のニューロンからの信号や実験的な刺激がこれに当たります。 - :カリウム(K⁺)、ナトリウム(Na⁺)、リーク(漏れ)チャンネルの伝導率

イオンが細胞膜を通過する際の通りやすさを表します。それぞれのイオンがどれだけ流れやすいかが発火に影響します。 - :カリウム、ナトリウム、リークの平衡電位

各イオンが自然に落ち着く電位です。この差が電気信号を生み出す原動力になります。 - :電位依存性ゲート変数

イオンチャンネルが開いたり閉じたりする確率を表します。これが時間とともに変化することで発火が調整されます。

この方程式は、ニューロンが外部からの刺激を受けると、膜電位が急速に変化し、活動電位(スパイク)と呼ばれる電気信号を発生させる過程を説明しています。具体的には、刺激が一定の閾値を超えると、ナトリウムイオンが一気に細胞内に流れ込み、その後カリウムイオンが外に出ることで電位が元に戻るのです。この一連の動きが、私たちが「考える」「感じる」といった活動の基盤となっています。

例えば、指先に熱いものが触れたとき、感覚ニューロンがこの仕組みで信号を発し、それが脳に伝わることで「熱い!」と認識するのです。ホジキン・ハクスリー方程式は、このような生命現象を数値でシミュレーションできるため、現代の神経科学や医療研究でも広く使われています。

1.2 シナプス結合とヘッブ則

こちらも変数を一つずつ見ていきましょう。

- :ニューロン から へのシナプス重みの変化量

シナプスの強さがどれだけ変わるかを示します。 - :学習率(シナプス強度がどれくらい変化するか)

学習のスピードを調整するパラメータです。大きければ変化が速く、小さければゆっくりです。 - :ニューロン の発火強度

発信元のニューロンがどれだけ活動しているかを表します。 - :ニューロン の発火強度

受信側のニューロンの活動レベルです。

この式が示すのは、「一緒に発火するニューロンは結びつきを強める」というシンプルかつ強力な原理です。例えば、友達の顔と名前を覚えるとき、視覚野で「顔」を認識するニューロンと、言語野で「名前」を処理するニューロンが同時に活動すると、それらのシナプスが強化され、次に顔を見たときに名前が自然と思い出されるようになります。

ヘッブ則は、脳の「学習」の基本メカニズムを説明するだけでなく、人工知能の分野でも重要な役割を果たしています。ニューラルネットワークと呼ばれるAIモデルは、この原理を参考にして設計されており、画像認識や音声処理など、私たちの生活を支える技術に活かされています。脳とAIが同じ原理でつながっているなんて、ちょっとワクワクしませんか?

2. 記憶の数学モデル

2.1 ホップフィールド・ネットワーク

この式の意味を分解してみましょう。

- :ネットワーク全体のエネルギー

ネットワークがどれだけ安定しているかを示します。エネルギーが低いほど安定です。 - :ニューロン から への結合強度(シナプス重み)

ニューロン間のつながりの強さを表します。 - :ニューロンの状態(+1 または -1)

ニューロンが「活動中」か「休止中」かを示す単純な値です。

このモデルでは、記憶が「エネルギーの最小点」として保存されると考えます。たとえば、子どもの頃に覚えた自転車の乗り方を思い出すとき、脳は関連するニューロンの状態を調整し、エネルギーが最も低い安定したパターンに戻そうとします。この過程で、部分的な情報(例えば「ペダルを踏む感覚」)から全体の記憶(「自転車に乗る方法」)が再現されるのです。

ホップフィールド・ネットワークの面白いところは、ノイズや欠けた情報があっても記憶を補完できる点です。たとえば、友達の名前を一部しか思い出せなくても、脳が自動的に残りを補ってくれることがありますよね。この特性は、コンピュータのエラー訂正技術にも応用されており、科学と日常のつながりを感じさせてくれます。

2.2 長期記憶と短期記憶(アトキンソン-シフリンモデル)

各変数の意味を見てみましょう。

- :長期記憶の強度

長期的にどれだけ記憶が定着しているかを表します。 - :短期記憶の強度

今まさに頭の中にある情報の強さです。 - :忘却率(記憶が消える速度)

時間が経つと記憶が薄れる割合です。 - :短期記憶が長期記憶に転送される割合

短期記憶が長期記憶に移行する効率を示します。

この式からわかるのは、短期記憶を長期記憶に変えるには「繰り返し」が大切だということです。たとえば、英単語を覚えるとき、一度読んだだけではすぐ忘れてしまいますが、何度も復習することで長期記憶として定着します。このを高める行為が、いわゆる「リハーサル(復習)」に当たるのです。

日常生活でも、このモデルを実感することがあります。たとえば、レストランで注文を聞いて一時的に覚えるのは短期記憶ですが、毎日のように同じメニューを頼んでいると、それが長期記憶として脳に刻まれ、自然に「いつもの」と注文できるようになります。脳のこの柔軟性が、私たちの学びを支えています。

3. 忘却のメカニズム

エビングハウスの忘却曲線

記憶がどれくらい持続するのかを知るために、ドイツの心理学者ヘルマン・エビングハウス(Hermann Ebbinghaus)は興味深い実験を行いました。彼は意味のない音節(例:「DAX」や「ZIF」)を覚え、時間が経つにつれてどれだけ忘れるかを測定しました。その結果を数学的に表したのが、エビングハウスの忘却曲線です。

この式の変数は次の通りです。

- :記憶の保持率

どれだけ記憶が残っているかの割合です(1が100%、0が0%)。 - :忘却速度(個人や情報の種類によって異なる)

記憶がどれくらいの速さで消えるかを決めます。 - :経過時間

学習してからどれだけの時間が経ったかです。

この式が示すのは、記憶が時間とともに指数関数的に減っていくことです。たとえば、新しい友達の名前を覚えた直後は100%覚えていますが、数時間後には70%、数日後には30%しか思い出せないかもしれません。エビングハウスは、意味のない情報を覚えた場合、最初の数時間で急速に忘れ、その後はゆっくり減っていくことを発見しました。

しかし、興味深いことに、この忘却速度は情報の意味や感情的な結びつきによって変わります。たとえば、感動的な映画のシーンは長く覚えている一方で、昨日食べた昼食の内容はすぐ忘れてしまうことがありますよね。この違いを理解することで、効率的な学習方法を考え出すヒントにもなります。

まとめ

ここまで、脳と記憶のメカニズムを数学モデルを通じて見てきました。最後に、これまでの内容を振り返ってみましょう。

- ニューロンの発火:ホジキン・ハクスリー方程式

電気信号がどのように発生するかを示しました。 - シナプス可塑性:ヘッブ則

「一緒に発火するニューロンは結びつきを強める」という学習の原理です。 - 記憶のモデル:ホップフィールド・ネットワーク、アトキンソン-シフリンモデル

記憶がどのように保存され、短期から長期に移行するかを表しました。 - 忘却の数式:エビングハウスの忘却曲線

時間が経つと記憶が減っていく様子を定量化しました。

これらの数学モデルを使うことで、脳の働きを抽象的な概念ではなく、具体的な数値として捉えることができます。たとえば、シミュレーションを通じて「どのくらい復習すれば記憶が定着するか」を予測したり、脳の病気でシナプスが弱まった場合の影響を計算したりできるのです。

今後、人工知能や脳科学がさらに進化することで、記憶の仕組みがもっと詳しく解明されるかもしれません。たとえば、特定の記憶を意図的に強化したり、忘れたい記憶を消したりする技術が生まれる可能性もあります。また、AIと脳の研究が融合すれば、私たちの学習能力を飛躍的に高めるツールが登場するかもしれません。そんな未来を想像すると、ワクワクしますね。

脳と記憶の研究は、私たちが「自分とは何か」を理解する旅でもあります。この記事を通じて、少しでもその魅力に触れていただけたら嬉しいです。これからも科学の進歩に注目しながら、私たちの脳の可能性を探っていきましょう!